ช่วงนี้ทวิตเตอร์ญี่ปุ่นมีกระแสฮิตเรื่อง AI ลงสีอยู่ ไหนๆ เราได้ลองแล้วก็เลยขอแนะนำให้รู้จักกันหน่อยกับ Style2Paints AI ลงสีภาพตัดเส้นอัตโนมัติที่พัฒนามาสุดๆ ทุ่นเวลาลงสีภาพวาดตัวละครได้มหาศาล

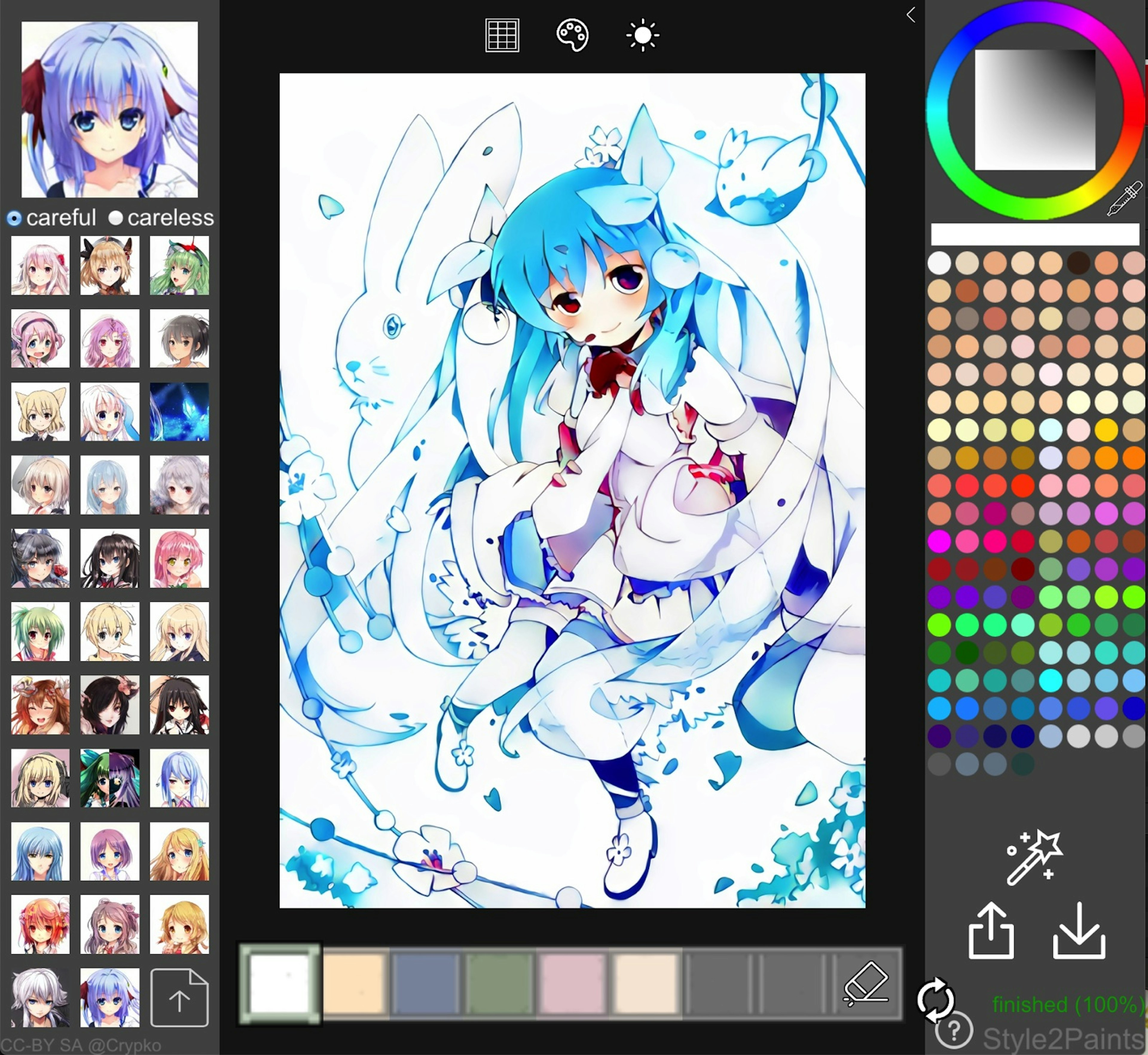

หน้าจอ Style2Paints และตัวอย่างผลลัพธ์

Style2Paints คือ

จากคำอธิบายเว็บผู้พัฒนา

Style2paints V4 is the current best AI driven lineart colorization tool.

Different from presious end-to-end image-to-image translation methods, style2paints V4 is the first system to colorize a lineart in real-life human workflow, and the outputs are layered.

แปลย่อๆ Style2Paints คือเครื่องมือลงสีภาพตัดเส้นด้วย AI ที่เจ๋งเพราะลงสีด้วยขั้นตอนเดียวกับคนทำ แยกเลเยอร์สี ไฮไลต์ และเฉดแสงอย่างที่คนทำเลย

Style2Paints พัฒนามาหลายปีอยู่ (หาไม่เจอว่าเริ่มเมื่อไร) โดยนักวิจัยชาวจีน ปัจจุบันอัพเดตมาถึง V4 เพิ่งรีลีสเมื่อวันที่ 2/11/2018 นี้เอง ผลลัพธ์ที่ออกมาดีกว่าเวอร์ชั่นก่อนๆ เยอะ เลยกลายเป็นกระแสดังเปรี้ยงขึ้นมา

https://twitter.com/IlIIlIIIllIllII/status/1055051687373635584

ทวีตจากผู้พัฒนา โชว์ผลลัพธ์การลงสีของ AI

วิธีใช้ Style2Paints

ลองเล่นได้ที่เว็บ Online App http://s2p.moe

วิธีใช้อ่านได้จาก Tutorial ของผู้พัฒนาข้างล่างนี้เลย

https://style2paints.github.io/

Workflow หลักๆ คือให้อัพรูปภาพตัวละครที่ตัดเส้นแล้ว (ภาพร่างก็พอไหว แต่สีจะรั่วเยอะหน่อย) ขึ้นไป แล้วเลือกภาพ Style ที่จะใช้อ้างอิงจากฝั่งซ้าย แล้วกดปุ่ม process ทางขวาล่าง แค่นั้น AI ก็จะลงสีให้เราเสร็จสรรพ ยังกับมีมายากลที่ไหนแน่ะ

ปุ่มคล้ายๆ magic wand กดเพื่อลงสี

ตัวอย่างผลลัพธ์อัตโนมัติ 100% ภาพจาก https://github.com/lllyasviel/style2paints

นอกจากให้ AI ลงสีอัตโนมัติ เราก็ช่วยเลือกสี guide ให้ AI ลงสีให้ตรงความต้องการเราได้ด้วย ลองเล่นกันตามสนุกครับ โพสนี้จะไม่ขอลงเทคนิคส่วนนั้น

เทคโนโลยีเบื้องหลัง Style2Paints

ในฐานะคนที่ทำงานเป็น Application Engineer พอเห็นเทคโนโลยีอะไรที่ไม่เข้าใจเราก็จะสงสัยว่าเบื้องหลังเป็นไง ไม่ยอมให้มันเป็น Magic ให้ได้ผลลัพธ์เทพๆ มางงๆ เด็ดขาด ก็จะขอสรุปเทคโนโลยีกับหลักการเบื้องหลังเท่าที่อ่าน Paper ที่ publish เมื่อปี 2017 แล้วทำความเข้าใจเองไว้ตรงนี้ ถ้าตรงไหนผิดก็รบกวนผู้รู้บอกด้วยนะครับ

Transfer for Anime Sketches

with Enhanced Residual U-net and Auxiliary Classifier GAN

หลักการทำงานก็คือ

- ใช้ VGG - Visual Geometry Group ในการแยกพาร์ทต่างๆ ของภาพ Reference หู ตา จมูก ปาก แขน ฯลฯ

- ย่อยพาร์ทต่างๆ เป็นเลเยอร์ Style สี

- แมพ Style สีเข้ากับพาร์ทของภาพ Input

- ประกอบพาร์ทเข้าด้วยกันเป็นภาพสำเร็จ

ในเปเปอร์ย่อนี้อธิบายว่าได้ Style จากภาพอ้างอิงยังไง แต่ไม่อธิบายเกี่ยวกับ Encoder/Decoder ของภาพ Input ก็เลยยังงงอยู่ว่าเขาแมพแต่ละส่วนของภาพ Input เข้ากับภาพ Reference ได้ยังไง แต่ก็พอจะเข้าใจได้ว่าแก่นของระบบนี้อยู่ที่การเทรนโมเดล VGG ให้สามารถแยกได้ว่าแต่ละส่วนของภาพที่ป้อนเข้าไปคืออะไร ถึงจะดึงสีมาใช้ได้ถูกต้อง เป็นการประยุกต์ใช้เทคโนโลยี Image recognition กับศิลปะที่เจ๋งมากๆ เดาได้ว่าต่อไปเราคงเห็นภาพวาดสีบ่อยขึ้นแน่ๆ ลงสีได้ง่ายขนาดนี้ คงไม่มีเหตุผลอะไรที่จะโชว์แต่ภาพลายเส้นเฉยๆ ขาวดำแล้วล่ะ

สำหรับตัวโปรแกรม Style2Paints และอัพเดตล่าสุด เช็คได้ที่ Github ของผู้พัฒนา สามารถ clone ไปรันบนคอมตัวเองได้ด้วย :)