[รีพอร์ต] xR Tech Tokyo #12 @ Mercari (2/2)

2018/10/21 วันนี้มีงาน xR Tech Tokyo ครั้งที่ 12 จัดที่บ. Mercari ที่ Roppongi รายละเอียด: https://vrtokyo.connpass.com/event/99826/ คอนเทนต์ที่มานำเสนอในวันนี้เป็นอะไรที่แปลกใหม่ดีมากๆ ก็จะขอรีพอร์ตความรู้ที่ได้ต่อจากโพสแรกครับ

Session 2 - งานวิจัยเพื่อสร้าง AR Content ที่มีความ Immersive สูง

งานวิจัยเพื่อสร้าง AR Content ที่มีความ Immersive สูง (没入度の高いARコンテンツ構築のために考えていること) เล่าโดย kidachi ซัง จากบ. Akatsuki บ.ทำเกมมือถือ เป็นการอธิบายผลงานวิจัยที่ได้นำเสนอในงาน VR/AR ด้วย SIGGRAPH 2018

@kidachi

@kidachi

-

FPS Game บน AR เล่นในลานจอดรถ

- องค์ประกอบ AR ที่จะทำให้ user เข้าเป็นส่วนหนึ่งของโลกนั้นได้ (= immersive)

- 1.幾何学的整合性 - Geometry ต้องรับรู้สภาวะแวดล้อมได้ถูกต้อง

- 2.光学的整合性 - Optics ต้องหลอมรวมภาพจริงเข้ากับ CG ได้อย่างเป็นธรรมชาติ

- 3.時間的整合性 - Performance FPS ต้องลื่น ไม่มี time lag

- ทำยังไงถึงจะหลอมรวม 3D CG เข้ากับความจริงได้ มีสองวิธี

- 1.Photorealistic Rendering พยายามเรนเดอร์ภาพเหมือนจริงเป๊ะๆ เป็น goal ของ CG หลายๆ ที่ แต่ยากมาก ต้องใช้พลัง GPU สูงมากๆ รันบนมือถือไม่ได้แน่นอนตอนนี้

- 2. Non-Photorealistic Rendering เป็น research ที่ผู้พูดกำลังทำอยู่ในบริษัท

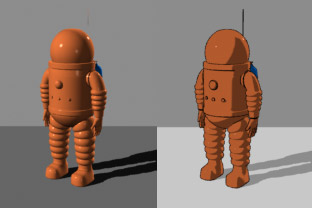

Non-Photorealistic Rendering (NPR)

ทางขวาคือ NPR ภาพจาก https://en.wikipedia.org/wiki/Non-photorealistic_rendering

- NPR เป็นเทคนิคเรนเดอร์ภาพแบบลดรายละเอียด ไม่เน้นความสมจริงเป๊ะๆ ตัวอย่างง่ายๆ คือ Toon shader ทั้งหลายแหล่ คือดูก็รู้ว่านี่เป็น CG ไม่ใช่ความจริง

-

โจทย์คือวิจัยว่า NPR ที่เหมาะกับ AR เป็นยังไง?

- ผู้พูดทดลองใช้ประสบการณ์ของ user ว่าเคยเห็นอะไรแบบนี้มาก่อนในหนัง หรือในสารคดี SF ทำให้แม้จะเห็นภาพที่เรนเดอร์แบบ NPR ก็คิดว่าเป็นสิ่งที่มีอยู่จริงได้

- Hologram แบบใน Starwars, Ghost in the shell

- Optical Camouflage ภาพใสๆ ซ้อนทับความเป็นจริงแบบใน Terminator

- ข้อดีของ NPR สำหรับ AR

- processing power ต่ำกว่ามาก ใช้งานได้จริง

- แยกความจริงไม่จริงได้ชัดเจน อะไรคือเกม อะไรไม่ใช่เกม

- เทคนิคที่วิจัยและใช้เช่น

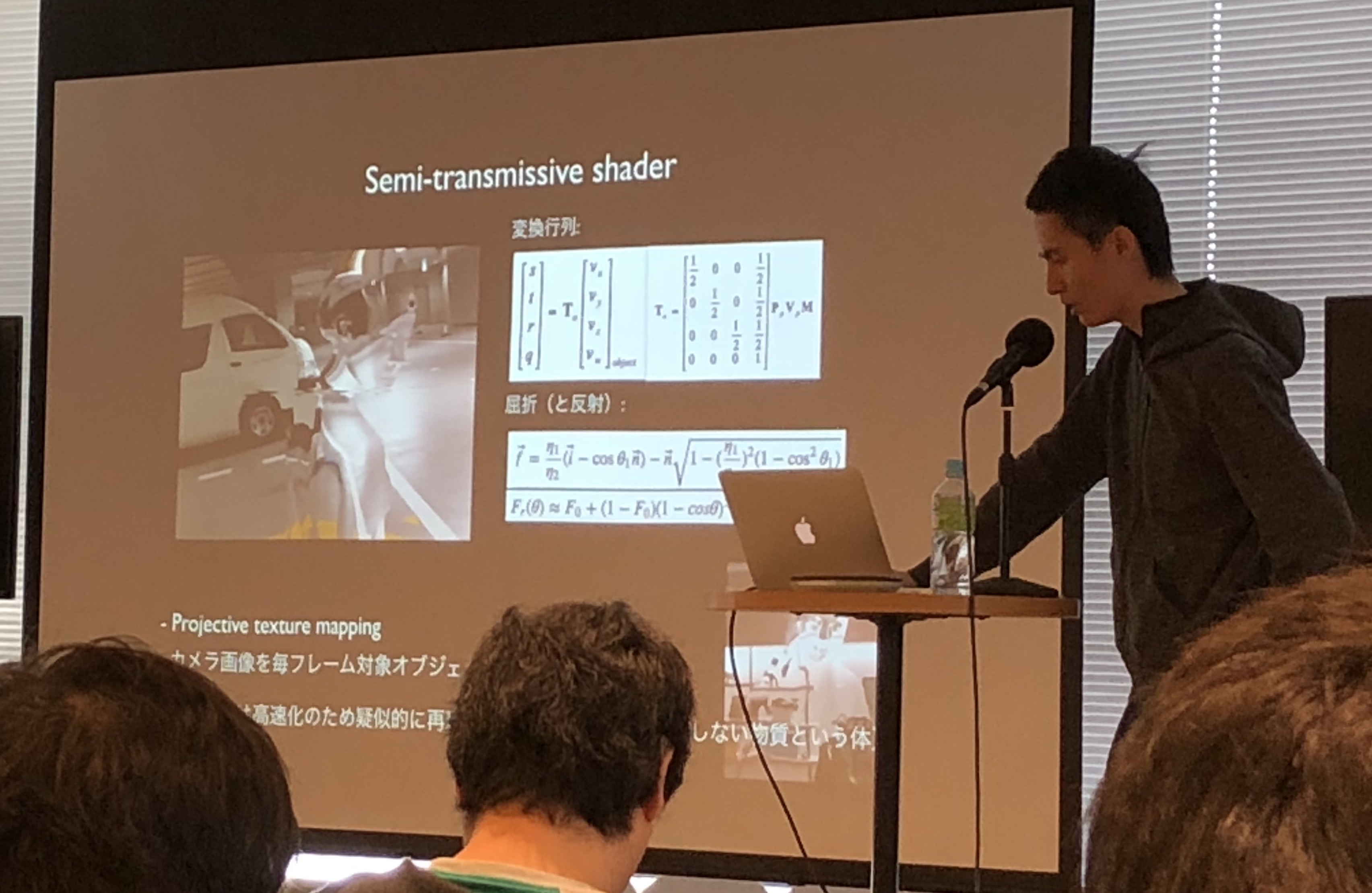

- Semi-transmissive shader

- Holographic shader

- Edge detection shader

- หลักการทั้งหมด based on simple shader และปรับให้เหมาะสมกับ mobile gpu ให้รันได้ 60fps ตลอด

- แล้วก็ดีไซน์ interaction ที่เหมาะสมด้วย

Semi-transmissive shader

Semi-transmissive shader

เรื่องวิจัยล่าสุด AR x Machine Learning

- โฟกัสไปที่องค์ประกอบ Optics ของ AR ก็คือการผสม 3DCG เข้าก้บ Environment

- หลักการนี้แปลว่าถ้า machine รู้เกี่ยวกับ environment มากเท่าไร ก็จะสร้างภาพที่หลอมรวมเข้ากับความเป็นจริงได้ดียิ่งขึ้น

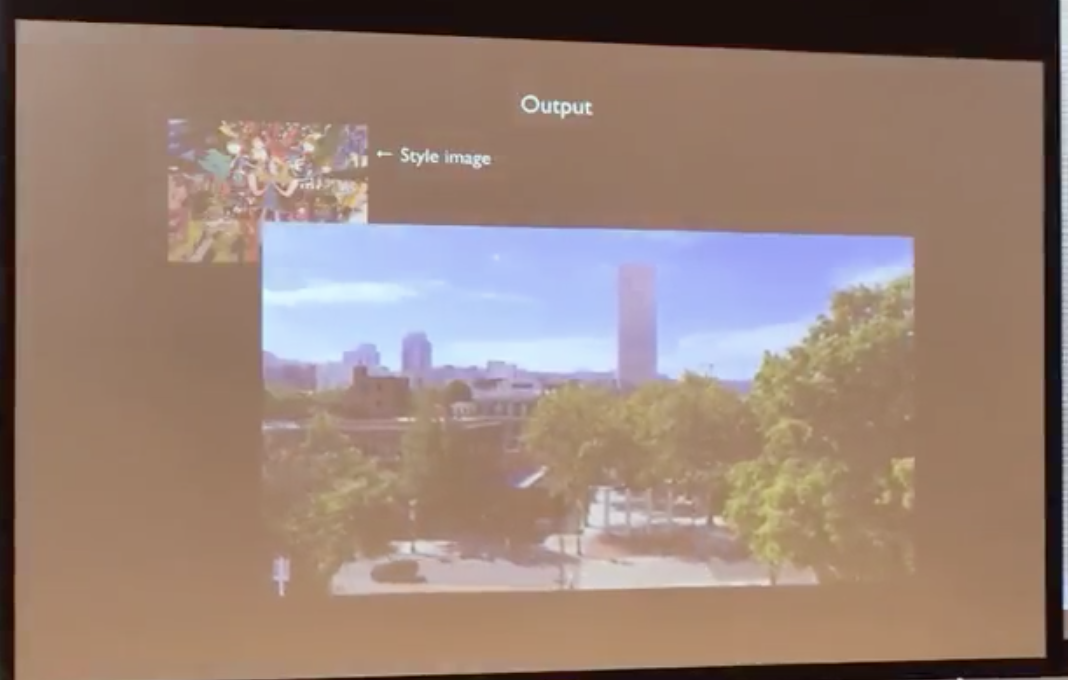

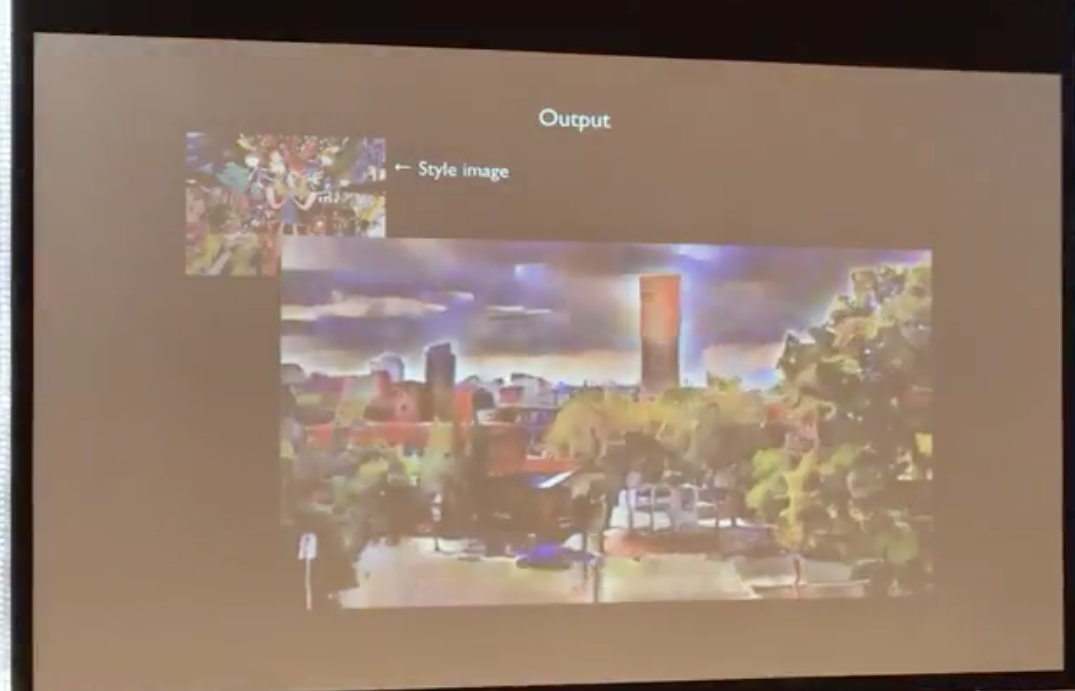

- ผลการวิจัยคือ การเรนเดอร์ style เข้าไปยังภาพจริง ใช้ภาพ bg จากโลกแม่มด madomagi ผสมกับฉากเมืองชิบุย่า ทำให้ได้โลกจริงที่เหมือนโลกแม่มดได้

- ความ unique คืองานวิจัยก่อนๆ ทำกับภาพ แต่เขาทำกับ video ทำให้มีความเป็นไปได้ที่จะนำมาประยุกต์ใช้กับเกมมากกว่าเยอะ

- ใช้กับ AR เปลี่ยนภาพโลกจริงแบบ real time สร้างโลก AR ที่เปลี่ยนบรรยากาศโลกความจริงไปโดยสมบูรณ์แบบ ส่องภาพปุ๊บเมืองไฟไหม้หมดเลย โลก SAO ก็คงเป็นจริงได้ในไม่ช้า สุดยอดๆๆๆๆ

- ปัญหาคือยังมี noise เยอะ แล้วก็เรนเดอร์ realtime ไม่ทัน ยังไม่เร็วพอที่จะใช้งานจริงได้ ยังต้องวิจัยต่อไป

ภาพเมือง Before ก่อนผสม style เข้ากับฉากแม่มด

ภาพเมือง Before ก่อนผสม style เข้ากับฉากแม่มด

ภาพเมือง After หลังผสม style เข้ากับฉากแม่มด ได้บรรยากาศมาโจสุดๆ

ภาพเมือง After หลังผสม style เข้ากับฉากแม่มด ได้บรรยากาศมาโจสุดๆ

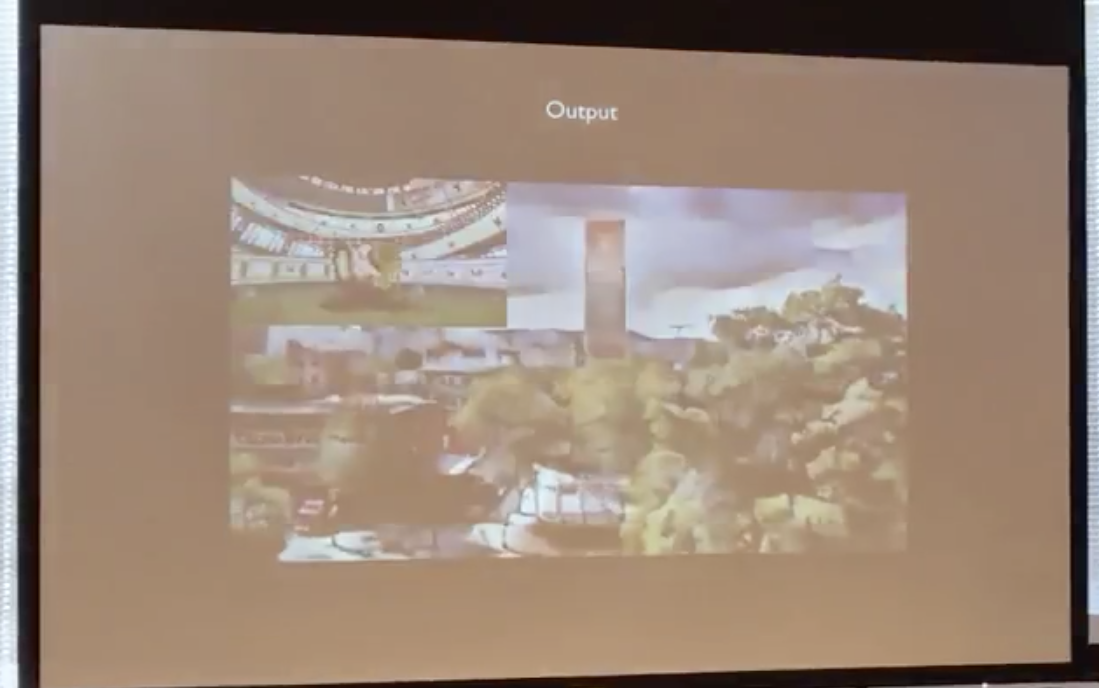

ยิ่งเจ๋งกว่าเมื่อเป็นวิดีโอ เปลี่ยน style ไปตามเสียงเพลง โลก SF สุดๆ

ยิ่งเจ๋งกว่าเมื่อเป็นวิดีโอ เปลี่ยน style ไปตามเสียงเพลง โลก SF สุดๆ

ความเห็นส่วนตัวเกี่ยวกับ Session นี้

สุดยอดดดดด เกม AR ที่เรนเดอร์โมเดลใสๆ เข้ากับโลกจริงอย่างเนียนก็เจ๋งแล้ว แต่เจ๋งกว่าคือการผสม style ภาพเข้ากับเมืองนี่แหละ อยากให้ได้เห็นคลิปกันจริงๆ พอรวมกับเพลงแล้วคือบรรยากาศเหมือนเราย้ายจากโลกแม่มดนึงไปอีกโลกจริงๆ ถ้าเทคโนโลยีนี้พัฒนาพอที่จะ render แบบเรียลไทม์บนมือถือได้** เชื่อว่ามิติของเกม AR จะพัฒนาไปอย่างก้าวกระโดด จินตนาการว่ายกมือถือเปิดกล้องปุ๊บ ก็เห็นเมืองไฟไหม้ มีบอสโผล่ออกมาให้สู้ดูสิ น่าสนุกกว่า AR ปัจจุบันที่แค่ส่งบอสออกมาบนภาพบ้านเมืองเดิมๆ 100 เท่า** โลก SAO ภาคหนังจะเป็นจริงในไม่ช้าแน่ ตื่นเต้น!!!

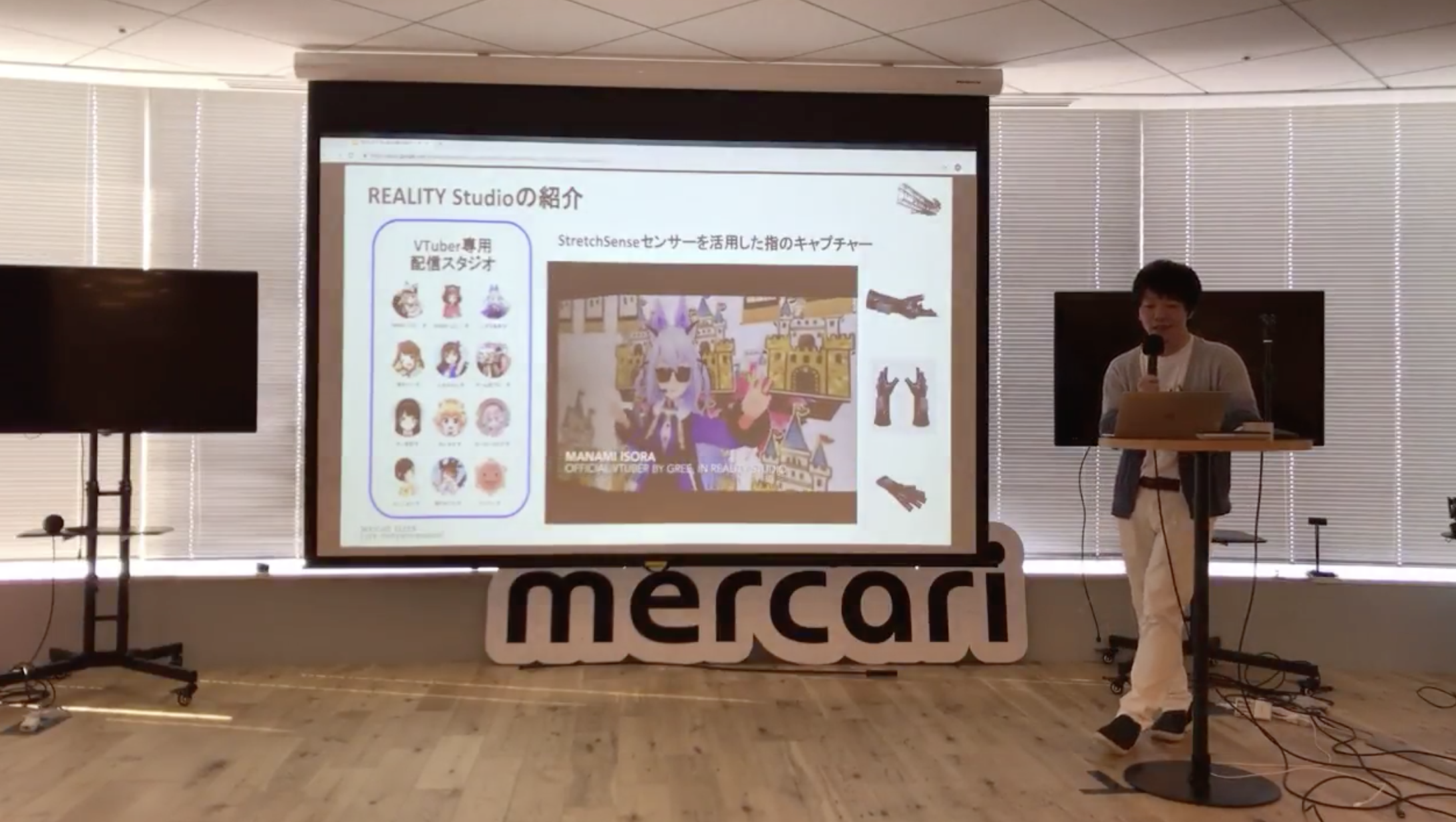

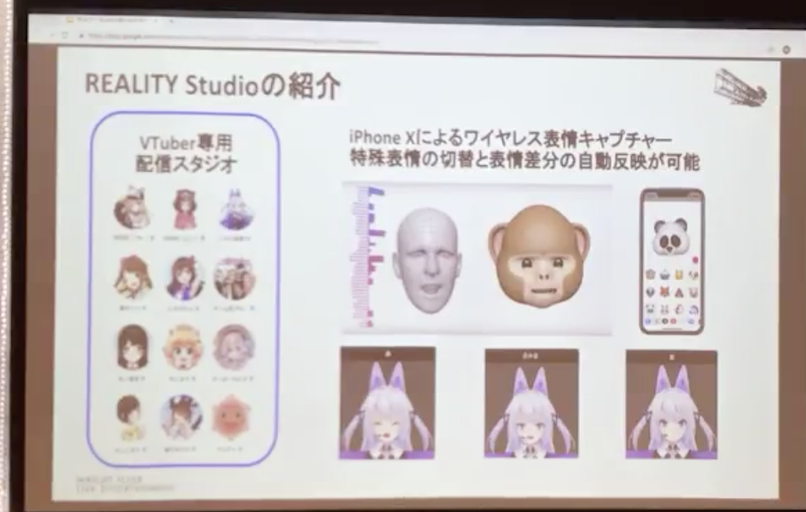

Session 3 - REALITY Studio สตูดิโอถ่ายทอดสดไลฟ์ VTuber ทุกวัน รายงานปัญหาและวิธีแก้ไข

REALITY Studio สตูดิโอถ่ายทอดสดไลฟ์ VTuber ทุกวัน รายงานปัญหาและวิธีแก้ไข (VTuberが毎日生配信!REALITY Studioで起こる課題とその解決策) ผู้พูดคือวาตานาเบะซัง บ.Wright Flyer Live Entertainment (WFLE) บ.ลูกของ GREE ที่ทำธุรกิจ VTuber Studio + App โดยเฉพาะ GREE ลงทุนให้กับธุรกิจนี้ถึง 10,000 ล้านเยน จริงจังมากๆ

VTuber คือ

ถ้ายังไม่รู้จักว่า VTuber = Virtual Youtuber คืออะไร แนะนำให้ไปดูไอจัง Kizuna Ai ผู้บุกเบิกวงการได้ที่ A.I. Channel (คนติดตามเกินสองล้านละ) พูดง่ายๆ ก็คือ Youtuber ที่ใช้คาแรกเตอร์ 3D มีคนคุมข้างใน ทำอะไรบ้าๆ บอๆ สนุกๆ หลายคนทำอะไรที่ Youtuber จริงทำไม่ได้ก็มี

REALITY Studio

REALITY แอพรับชม VTuber live สดๆ

REALITY แอพรับชม VTuber live สดๆ

REALITY Studio เป็นชื่อสตูดิโอที่ WFLE สร้างขึ้นมาเพื่อถ่ายทอดสด VTuber โดยเฉพาะ นักแสดงมาตัวเปล่าได้เลย ถือเป็น platform ครบวงจรตั้งแต่ capture-บันทึก-ถ่ายทอดสด ส่วนทางฝั่งผู้ชมต้องโหลดแอพ REALITY มาดูบนมือถือ หลักการแอพนี้ก็เหมือนแอพชมไอดอลถ่ายทอดสดอย่าง SHOWROOM ให้กิ๊ฟกับ VTuber ได้ ก็ทำเงินส่วนหนึ่งจากตรงนี้

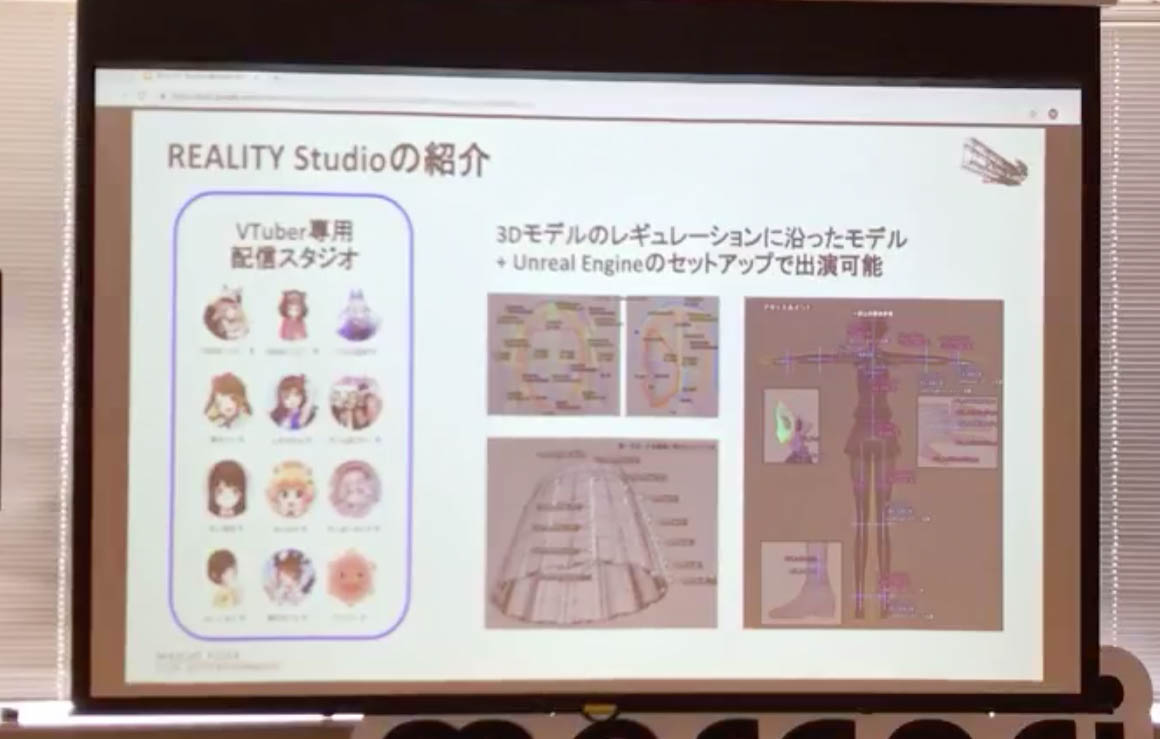

REALITY Studio

REALITY Studio

เทคโนโลยีที่ใช้มีดังนี้

- Vtuber โมเดล ต้องสร้างโมเดลที่เข้ากับ format ที่ใช้ใน unreal engine ได้ มีข้อจำกัดด้าน rigging ที่ต้องรองรับ gift equipment ที่จะสวมใส่เพิ่มได้

- Face capture ใช้ iPhone X + wireless ส่งไปเข้าคอม

- Motion capture ใช้ Vive Tracker, IKinema Orion

- Finger capture นิ้ว ใช้ StretchSense

- เตรียมระบบแบบ Portable ให้ออกไปแสดง live ข้างนอกตามอีเวนต์ต่างๆ ได้ด้วย

- ตอนนี้นักแสดงใช้ได้ 8 คนพร้อมกัน ใช้ PC สองเครื่อง แบ่งเป็น Capture engine + Rendering Engine

- มีระบบกล้องและเสียงพร้อม สตูดิโอเป็นของจริง ไม่ใช่ virtual ต่างกับของ cluster ที่พูดใน session 1

- Gift System พร้อมความเจ๋งตรงที่ผู้แสดงสามารถสวม gift บางอย่างที่เป็น equipment แล้วเล่นได้ด้วย ไม่ใช่แค่รับมาเฉยๆ

โมเดล VTuber

โมเดล VTuber

iPhone X Facial Capture

iPhone X Facial Capture

ปัญหามากมายและวิธีแก้

-

Vive Tracker เพี้ยน ต่อไร้สายใช้ได้จำกัดจำนวน เลยเปลี่ยนเป็นลากสายแล้วมัดสายไว้ให้เรียบร้อยแทน

- Tracking มั่ว (ออกอาละวาด) เพราะ Infrared สะท้อนมอนิเตอร์ เลยซื้อแผ่นต้านการสะท้อนอินฟราเรดมาติด ข้อเสียคือทำให้มองเห็นจอยากขึ้นหน่อย

- iPhone X Rigging หนัก เพราะต้องติด iPhone ไว้ข้างหน้าหัว เป็นปัญหากับนักแสดง เลยเปลี่ยนเป็นตั้งไอโฟนบนสแตนด์แล้วยืนแสดงข้างหน้าแทน ทำให้นักแสดงขยับได้น้อยลง แต่ไอโฟนมันเจ๋ง อยู่ไกลซักหน่อยก็ยังจับได้อยู่

- ถุงมือ Stretch Sense ของไม่ส่งมอบซักที เลยเปลี่ยนเป็นใช้ gamepad คุมนิ้วแทนไปก่อน

- Vive Tracker หลุดจากตัว เลยต้องทำ mount สำหรับมันโดยเฉพาะขึ้นเอง

- การประมวลผลของส่าย (揺れもの) แบบ realtime มีปัญหา กระโปรงทะลุเข้าไปในโมเดลบ้างอะไรบ้าง จะหยุดแก้ก็ไม่ได้เพราะถ่ายทอดสด เลยเตรียมปุ่มรีเซ็ตไว้ให้นักแสดงแก้ปัญหาได้เอง

- ขนาดโมเดลกับคนแสดงไม่เท่ากัน ทำให้การขยับข้อไม่เป็นธรรมชาติ แก้โดย Orion A Pose + IKinema Rig

- Expression เปลี่ยนไปตามสภาพร่างกายและคนแสดง เลยเตรียม facial calibaration ไว้ ปรับให้เหมาะกับนักแสดงแต่ละคน ให้รู้ว่าเวลาเปิดปากกว้างเป็นไง หน้าปกติเป็นไง

- IKINEMA Orion motion capture ค่อนข้างใช้งานลำบาก (ต้องติด vive tracker + calibrate ทุกครั้ง) เลยกะเปลี่ยนเป็น MNV Link ดู ตอนนี้กำลังทดลอง (ปัญหาคือแพง)

- ปัญหาระหว่าง Live ต้องเตรียม ฝึกซ้อม rehearsal เยอะๆ เตรียม flow แก้ปัญหาไว้ แบบเดียวกับ cluster

REALITY Avatar

- แอพสร้าง Avatar ของตัวเองถ่ายทอดสด live ได้เลยบน iPhone X โหลดได้แล้ว

ความเห็นส่วนตัว

WFLE เป็นบ.ที่เราไปสมัครงานมาตอนหางานใหม่เดือนมิ.ย. แต่ตกไป ตอนนั้น REALITY ยังเป็นวุ้นอยู่เลย คือพอจะเดาได้ว่า engineer ข้างในกว่าจะเข็นออกมาได้คงทำงานกันหามรุ่งค่ำ ออกมาเป็น platform ที่เต็มไปด้วยความฝันอย่างนี้แล้วก็ดีใจด้วย (+เสียใจกับตัวเองที่ความสามารถไม่ถึง เข้าไม่ได้)

เทคโนโลยีเบื้องหลังสตูดิโอเป็นความรู้ใหม่ดี จะ capture ทั้งนิ้ว หน้า และโมชั่นไปพร้อมกับถ่ายทอดสดนี่ต้องลงทุนขนาดนี้เลย แต่อีกไม่กี่ปีเทคโนโลยีคงทำให้คนเป็น VTuber กันได้ง่ายๆ ถึงตอนนั้น ถ้า REALITY platform นี้เป็นที่แพร่หลาย คนเข้าไปโพสคลิปกันเป็นที่หนึ่ง ปาของขวัญให้กัน ก็คงทำกำไรให้ GREE เพียบตามที่หวังล่ะมั้ง แต่ตลาดนี้แข่งขันกันแรงมาก ตอนนี้ก็มี Custom Cast, VKatsu มาเป็นแอพแล้วด้วย ใครจะชนะก็ไม่รู้ รู้แต่ว่าคอนเทนต์สาวโมเดล 3D ออกมาเกลื่อนแน่นอน

ไหนๆ เทคโนโลยีก็เอื้อขนาดนี้แล้ว เราเองก็อยากจะแปลงร่างเป็นสาวน้อยน่ารักแล้ว stream อะไรซักอย่าง แต่เพราะไม่เคยพูดอะไรสดๆ ให้คนสาธารณะฟัง ก็เลยไม่กล้าซักที เท่าที่รู้คือ VTuber โคตรไม่มีข่าวในไทย ถ้าทำอะไรที่มันน่าสนใจก็คงจุดกระแสได้อยู่ ต้องลอง!!